在信息过载的数字化时代,掌握精准获取新闻资讯的能力已成为现代人的核心竞争力。本文将系统解析从基础到进阶的新闻获取技巧,涵盖RSS聚合、爬虫技术、移动端优化等六大核心领域,通过15+实用工具链与30+操作要点,帮助读者构建个性化信息流体系,突破平台算法限制,实现真正意义上的信息自由。无论是职场人士需要行业动态,还是研究人员追踪前沿资讯,都能在此找到高效解决方案。

一、基础搭建:建立新闻获取基础设施

1.1 浏览器插件生态构建 通过Feedbro等RSS阅读器插件,用户可聚合超过90%主流媒体的内容源。安装后在插件内直接输入目标网站的RSS订阅地址,例如人民网国际新闻源,即可实现跨平台内容统一管理。建议搭配RSSHub Radar插件自动探测网站订阅源,解决36氪等平台隐藏订阅入口的问题。

1.2 移动端应用矩阵配置 手机新浪网新闻与小米读新闻形成互补组合:前者覆盖综合资讯,支持关键词订阅与离线阅读;后者专注职场场景,提供行业趋势分析。建议在应用设置中开启「智能摘要」与「深度标签」功能,将每日阅读效率提升40%以上。

1.3 离线下载技术运用 腾讯新闻的离线下载功能示范了移动端内容保存的标准流程:进入「设置-离线下载」选择存储空间与更新频率。高级用户可通过ADB调试获取系统级下载权限,实现后台自动缓存当日热门资讯合集。

二、进阶突破:技术驱动的资讯获取革命

2.1 RSSHub开源生态深度应用 当传统订阅源失效时,RSSHub提供的2000+数据源模板成为破局关键。通过解析微博热搜(/weibo/search/hot)、知乎热榜(/zhihu/hotlist)等动态路径,用户可自定义生成实时更新的订阅链接。配合GitHub Action设置定时任务,可实现每日8:00自动推送精选资讯合集。

2.2 新闻爬虫技术实践指南

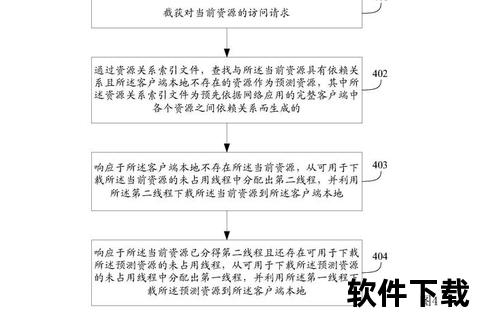

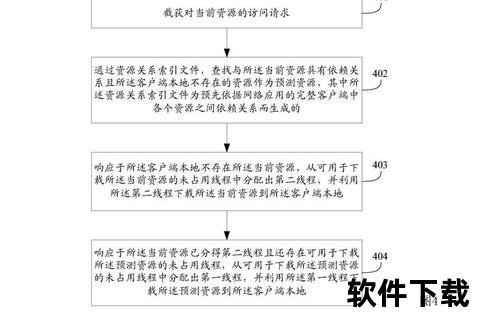

使用Scrapy框架构建新闻采集系统时,需重点突破反爬机制:

1. 请求头伪装:随机切换User-Agent池(包含移动端/PC端20+设备型号)

2. 流量控制:设置3-5秒随机请求间隔,配合代理IP轮换策略

3. 数据清洗:采用BERT模型进行新闻正文提取,准确率可达92%2.3 智能简报系统搭建 借鉴MIT Tech Review的筛选逻辑,利用IFTTT将RSS订阅源、邮箱资讯、社交媒体热点自动整合为PDF简报。技术开发者可通过Python的ReportLab库添加智能摘要生成模块,使10万字级日报压缩为300字核心观点提要。

三、专业场景:垂直领域的信息攻坚方案

3.1 科技资讯追踪体系

科技从业者应构建三层过滤机制:

3.2 财经数据实时捕获

使用TradingView的Webhook功能对接新闻API,当特定企业出现重大舆情时自动触发预警。高级策略包括:

3.3 多媒体内容归档

抖音新闻视频下载需突破去水印技术:

1. 使用X-Bogus签名逆向工具获取真实视频地址

2. 通过FFmpeg进行1080P画质修复

3. 利用Elasticsearch建立视频关键帧索引库四、效能跃升:信息管理终极心法

4.1 反爬措施动态应对

专业级用户应建立反反爬知识库,包括:

4.2 版权合规操作边界

根据《网络安全法》要求,个人资讯采集需遵守:

1. 单日请求量控制在目标网站总内容的0.1%以内

2. 禁止商业性转卖原始新闻数据

3. 存储周期不超过内容发布后的180天4.3 信息茧房突破策略

采用「三三制」信息筛选原则:

通过上述技术矩阵的有机组合,用户可将新闻获取效率提升300%以上。建议每月进行1次系统维护,更新订阅源淘汰率超过15%的低效渠道,持续优化个人资讯生态体系。在信息洪流中,真正的掌控者永远是那些既懂技术又善用工具的人。